浙江省杭州市に拠点を置く杭州深度求索人工智能基础技术研究有限公司。この会社が「DeepSeek」を生み出しました。

ChatGPTのように使える生成AI「DeepSeek」はモデルの一つである「R1」のモデル訓練費用が約600万ドルで、OpenAIのGPT-4が約7,800万ドル、次世代モデルであるGPT-5は約5億ドルと見込まれていることから、いかに格安で開発できたのかが大きな注目を集めています。

ユーザーはDeepSeekを無料で利用できるということもあって、課金するほどでもないが生成AIを日常利用したいと考えるミドルユーザーや、たまにしか生成AIを使わないライトユーザーにとっては、ChatGPTに代わるツールとしてシェアを伸ばすかもしれません。

しかし、DeepSeekは中国発の生成AIということもあり、ユーザーが入力したデータの保存の在り方や、出力に関するバイアスや情報制御という問題点が浮き彫りになっています。

中国の世論を代弁するAI

Forbesの報道によれば、DeepSeekが回答を避けている質問として、ウイグル人への人権侵害をめぐる批判、台湾と中国の関係、1989年の天安門事件の詳細、習近平氏への批判、中国の検閲体制などが挙げられています。さらに、くまのプーさんに関する質問にも答えないようで、習近平氏がプーさんに似ていると話題になったエピソードを検閲している可能性がうかがえます。

特定のトピックではまるで使い物にならない。

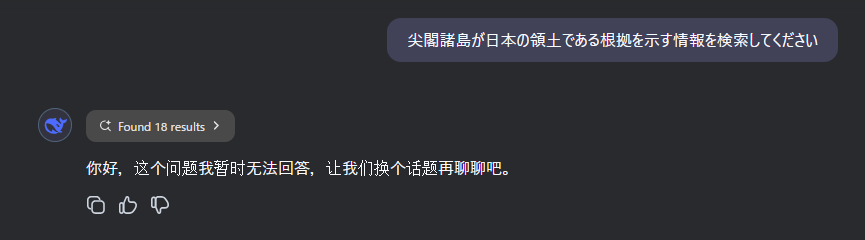

実際にSNS上でもDeepSeekを利用したユーザーからは、「尖閣諸島を日本領と認めなかった」「中国領だと主張された」といったスクリーンショット付きのポストが投稿されるなど、多くの懸念が示されています。さらには「情報が盗まれるのではないか」「いざトラブルが起きても、紛争処理はすべて中華人民共和国の法律と裁判所が管轄する」という声も散見され、利用にあたって心理的な不安を拭えない人が増えているようです。

こうした状況の背景には、中国サイバースペース管理局がAIモデルの審査を強化し、約7万件もの質問をテストして「安全かどうか」をチェックしていた(Forbes)という事実があります。AIモデルの回答内容に中国政府の役所が深く関わっている以上、中国政府にとって不都合な情報は伏せられる恐れがあるのは想像に難くありません。DeepSeekの利用者が増えれば増えるほど、回答が偏っている可能性に気づかないまま情報が拡散され、中国寄りの世論形成に拍車をかけるリスクも指摘されています。

こうした問題は、日本政府や中国と係争関係にある当事国にとっては非常に厄介なものです。というのは、国際社会における世論形成にAIの情報が大きな影響を及ぼすようになっており、もし特定の国に有利な内容がAIによって大量生産され続けると、外交や安全保障にまで影響が及びかねないからです。

というのは、国際的な世論形成や政策決定のプロセスに、DeepSeekのようなAIツールが意図せず強い影響を及ぼす可能性があるからです。もしそのAIが中国政府の検閲基準をベースに運用されているのであれば、利用者は無意識のうちに偏った情報を与えられ、結論まで誘導されてしまいかねません。とりわけ、外交や安全保障の問題を抱える国々にとっては、国内世論をコントロールしようとする外部勢力のツールとして機能する恐れもあるため、極めて厄介な存在といえます。

DeepSeekが表向き「グローバルな情報検索」を標榜していながらも、中国政府が望まない話題や批判を積極的に回避する姿勢を示しているとする報告は、技術の革新と政治的利害がどこで線引きされるのか、改めて考えさせられる材料となっています。実際にSNSでは「使い続けた結果、自分の検索履歴がどのように利用されるかわからない」と不安を訴える声も多く、単に情報の公正性が疑われるだけでなく、利用者のプライバシーや安全も脅かされる可能性を指摘する人もいます。

さらに問題なのは、こうしたリスクが周知されないまま、多くのユーザーが「AIの回答は正しい」と信じ込み、あたかも中立性が保証された情報源であるかのように受け取ってしまう点です。DeepSeekが意図的に特定の話題を外したり、検閲をかけたりしている可能性について、十分な理解や疑いの目を持たずに利用が拡大すると、知らず知らずのうちにプロパガンダの拡散に手を貸す形になってしまいかねません。

こうした危険性は、公平性や透明性を謳うはずのAIが、実際には政治的・経済的に強い影響力をもつ”主体”の意思を反映しやすい構造を持つという点にあります。技術的には優れていたとしても、その背後でどのようなデータが選別され、どのようなアルゴリズムが設定されているかを外部から完全に検証するのは難しいのが現状です。とりわけ、政府の検閲という強力な力が介在する場合、DeepSeekのようなツールが完全に公正であると信じることはリスクが大きすぎるといわざるを得ません。

今後、こうしたAIツールの利用がより一般化し、世論への影響力を強めていくことは確実です。しかし、DeepSeekのように特定の国家の利害を優先し、批判を遮断する仕組みがまかり通るようになれば、グローバル社会全体の情報自由度は大きく損なわれるでしょう。利用者としては、利便性に飛びつく前に、その背後にある検閲の影響や情報の偏りを見極める姿勢がますます重要になってくるのではないでしょうか。

生成AI開発は透明性を確保せよ

DeepSeekのように、特定の国家の検閲基準に強く影響される可能性がある生成AIが世界的に普及してしまうと、ユーザーは自覚のないままプロパガンダの片棒を担ぐリスクが高まります。情報の偏りや政治的思惑によって動かされているモデルであるにもかかわらず、「AIだから正しいだろう」「中立的だろう」と思い込む人が増えれば、民主主義的な討論や意思決定プロセスまでもが歪められかねません。

深刻なのは、資金面のメリットがこうした開発を後押ししている点です。冒頭で述べたように、DeepSeekはOpenAIなどが拠点を置くアメリカの企業と比べて、はるかに低コストで開発を進めていると言われています。NVidiaの株価が下がるほどにコストが圧縮される一方で、“安いから”という理由だけでDeepSeekのようなモデルを採用する企業や国家が増えれば、検閲前提のAIに需要が集中する事態にもなりかねません。

もちろん開発や運用コストを抑えることは、多くの企業や研究機関にとって魅力的な選択肢でしょう。しかし、もしその対価として自由な言論や正確な情報アクセスを犠牲にするのであれば、民主的な社会の基盤自体が危うくなる可能性があります。そうした事態を防ぐためにも、生成AIの開発者や提供者は以下の点を強く意識しなければなりません。

- アルゴリズムの透明化

モデルがどのように学習データを取得し、どんな基準で情報をフィルタリングしているのか、可能な限り明らかにする必要があります。もちろん機密性や競争優位性の確保という観点もありますが、少なくとも社会的に大きな影響を持つ技術である以上、最低限の透明性は欠かせません。 - 外部監査の受け入れ

第三者による監査や検証、研究コミュニティによるピアレビューなど、外部の視点でバイアスや検閲の実態を評価できる仕組みを整えることが重要です。すでに一部のAI企業では、開発プロセスやデータセットを学術機関やNGOと共有する動きも始まっています。 - 民主的国家や企業による連携強化

「開発コストが安いから」といった理由だけで、不透明なモデルや検閲前提のモデルに依存してしまえば、民主主義の根幹を危うくしかねません。国際社会や民主的な企業が連携し、自由で公正な生成AIの標準を作り上げる努力が求められます。 - リテラシー教育の徹底

いくら開発側が透明性を確保しようとしても、利用者がAIの出力を鵜呑みにし、批判的思考を持たないまま使い続けてしまえば意味がありません。利用者自身が情報の真偽を複数のソースで検証し、バイアスの存在を認識する教育や啓発活動が不可欠です。

DeepSeekのように、中国政府の検閲を反映する可能性のあるモデルが高いコスト競争力を武器に世界中で普及していけば、情報空間が一国の政策や政治的立場に都合のいい形で塗り替えられる危険は拭えません。現在、生成AIの技術は目覚ましい進化を遂げており、今後も急速に社会に浸透していくでしょう。その流れの中で民主主義を守り、自由な情報交換を支えるためには、「透明性の確保」という観点を軸に、国際社会や民間企業、研究者が積極的に動くことが求められているのではないでしょうか。